A fronteira invisível entre realismo e desinformação: quando o olhar da IA distorce a ciência

Uma especialista em fertilidade pediu à IA para criar um vídeo educativo sobre reprodução — e descobriu que o realismo visual pode esconder uma ficção científica perigosa.

O experimento: quando a IA tenta explicar a fertilidade humana

A médica e escritora Amanda Smith, colunista da CNET, decidiu testar os limites da Sora, o sistema de geração de vídeo por IA da OpenAI, criadora do ChatGPT. Sua ideia parecia simples: criar um vídeo educativo sobre fertilização in vitro (FIV) para leigos — algo didático, visual e acessível.

Mas o resultado foi tudo, menos científico.

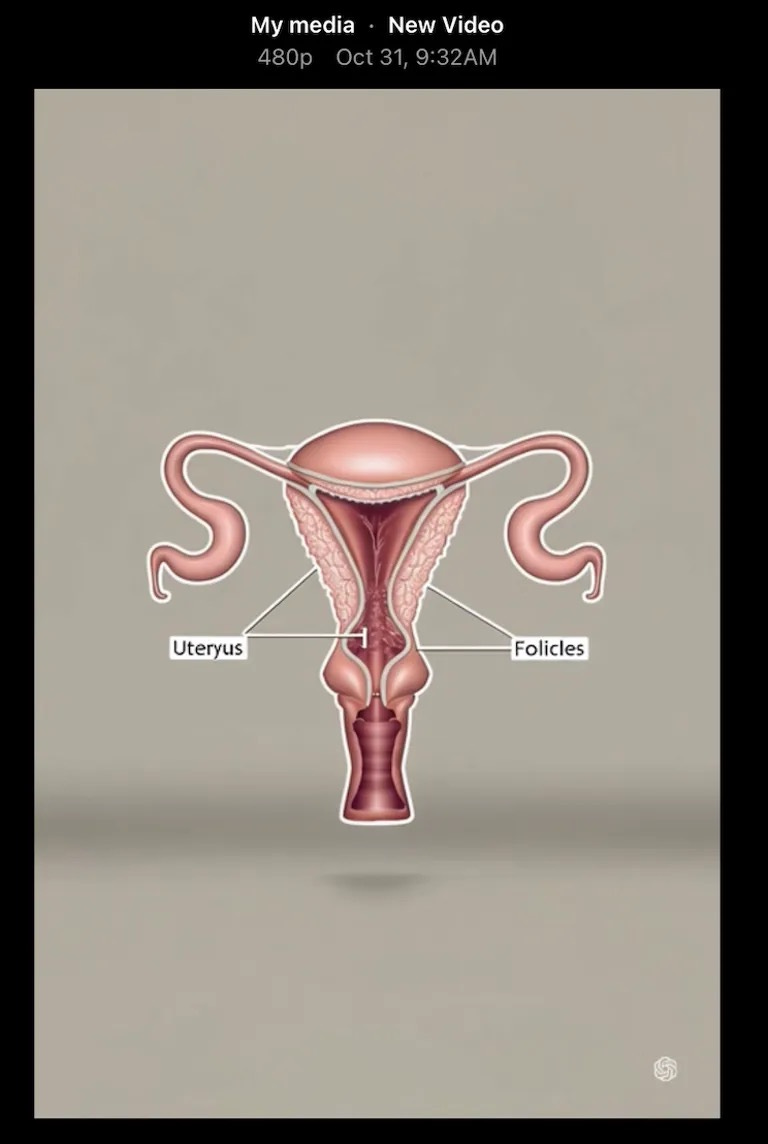

A Sora entregou imagens bonitas, convincentes, até emocionantes. Porém, à medida que Amanda observava os detalhes, algo incomodava. A IA havia misturado conceitos médicos, confundido etapas do processo e até inventado procedimentos inexistentes.

(Se você quiser ver os prompts usados e os resultados bizarros gerados pela Sora, confira o artigo original da CNET — o link está no fim do artigo.)

A precisão visual da Sora e a imprecisão médica

O paradoxo era evidente: quanto mais real o vídeo parecia, mais perigosa se tornava sua imprecisão.

A IA mostrava médicos manipulando tubos errados, embriões se desenvolvendo em lugares impossíveis e instrumentos que não existem na prática clínica. Para quem não entende do assunto, nada disso soava estranho.

É o novo tipo de desinformação — não textual, mas visual. Não se trata mais de ler uma fake news, mas de ver uma mentira perfeitamente renderizada.

O fascínio (e o risco) da autoridade estética

Amanda percebeu que a força da IA está em algo sutil: a estética da autoridade.

Um vídeo em alta definição, com iluminação de cinema e gestos realistas, parece correto. E quando o público acredita no que vê, a linha entre verossimilhança e verdade científica desaparece.

O perigo é silencioso — não porque a IA “queira” enganar, mas porque a ilusão visual é mais convincente do que a dúvida racional.

IA e medicina: quem valida o que é verdade?

O episódio expõe uma questão essencial: quem deve validar conteúdos gerados por IA em áreas críticas como saúde e ciência?

Empresas de tecnologia ainda tratam esses sistemas como ferramentas criativas, mas o público os recebe como fontes de autoridade. O resultado é uma zona cinzenta entre entretenimento e informação científica — uma área onde um erro “cinematográfico” pode moldar crenças sobre o próprio corpo humano.

O que o caso da Sora revela sobre o futuro da informação científica

A experiência de Amanda é mais que um relato curioso: é um alerta sobre o poder da aparência na era da IA generativa.

A tecnologia já consegue produzir imagens mais convincentes do que a realidade, mas ainda não entende o que está dizendo.

E isso coloca sobre nós — médicos, jornalistas, criadores e cidadãos — a responsabilidade de reconstruir o senso crítico visual, algo que as máquinas ainda não possuem.

Porque o verdadeiro risco talvez não esteja no que a IA mostra, mas em quanto estamos dispostos a acreditar nela.

Conclusão

Apesar do avanço impressionante da inteligência artificial, nenhum algoritmo substitui o olhar humano sobre a veracidade. Cada vídeo, áudio ou texto gerado por IA precisa ser questionado, verificado e contextualizado. Do contrário, as chamadas alucinações desses sistemas deixam de ser meros erros técnicos e passam a se infiltrar como verdades aceitas. O risco não está apenas na máquina que inventa, mas na sociedade que deixa de conferir.

Qual a sua opinião a respeito? Deixe suas dúvidas, opiniões nos comentários!

📖 Leitura original:

When AI Gets Fertility Wrong: My IVF Journey Through Sora’s Inaccurate Lens, por Amanda Smith, na CNET.

Muito bom esse artigo. Importantíssima essa visão de que a ciência sempre necessitará do olhar e conhecimento humano.

Excelente artigo para o momento de "aprendizado" sobre IA, em que vivemos. É um alerta fundamental sobre a importância da aplicação do senso critico humano e do conhecimento cientifico já alcançado pela humanidade aos produtos gerados por IA, sob pena de disseminarmos desinformação no lugar de informação e cultura.